HADOOP

[ Hadoop ] HDFS 에 파일 UPLOAD 하기

Jerry_JH

2022. 2. 25. 17:18

728x90

HIVE에 데이터를 LOAD 하는 방법은 여러가지가 있다.

LOCAL DATA를 바로 LOAD하는 방법도 있지만, HDFS에 적재하고 LOAD하는 방법도 있다.

(HDFS : Hadoop Distributed File System)

여기서는 HDFS에 파일을 적재하는 방법에 대해 설명하는 글이다.

당연히 Hadoop 이 설치되어있고, 현재 구동 중인 상태여야 가능하다.

1. Hadoop을 구동시키고, 터미널에 접속한다.

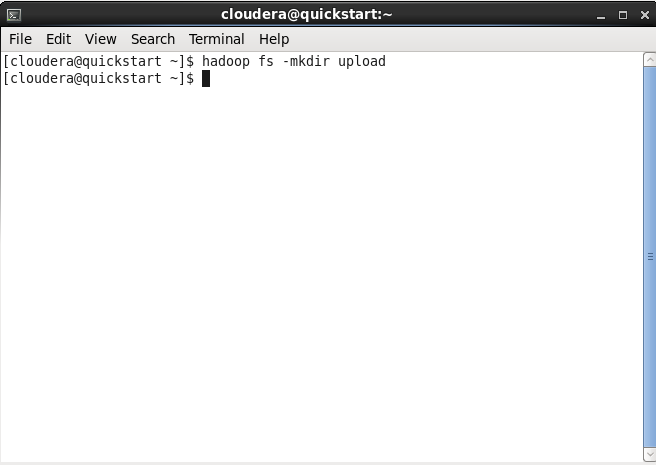

2. HDFS에 DATA를 넣을 폴더를 먼저 만든다. (있다면 굳이 안들어도 된다.)

$ hadoop fs -mkdir [폴더이름]

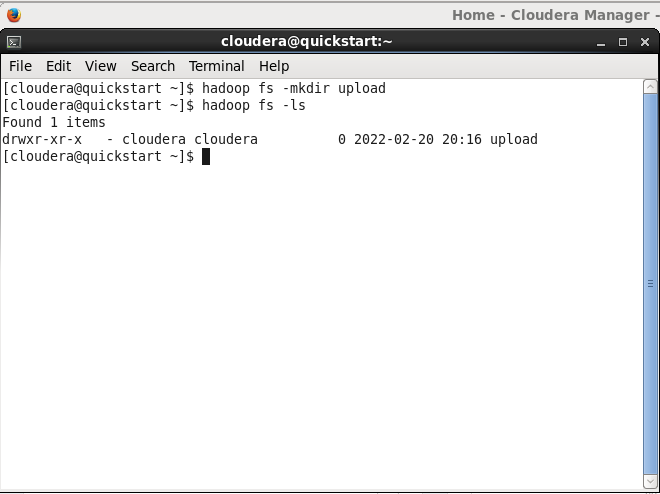

2-1. -ls 명령어를 입력하면 현재 위치의 파일(폴더포함)들 목록을 볼 수 있다.

$ hadoop fs -ls

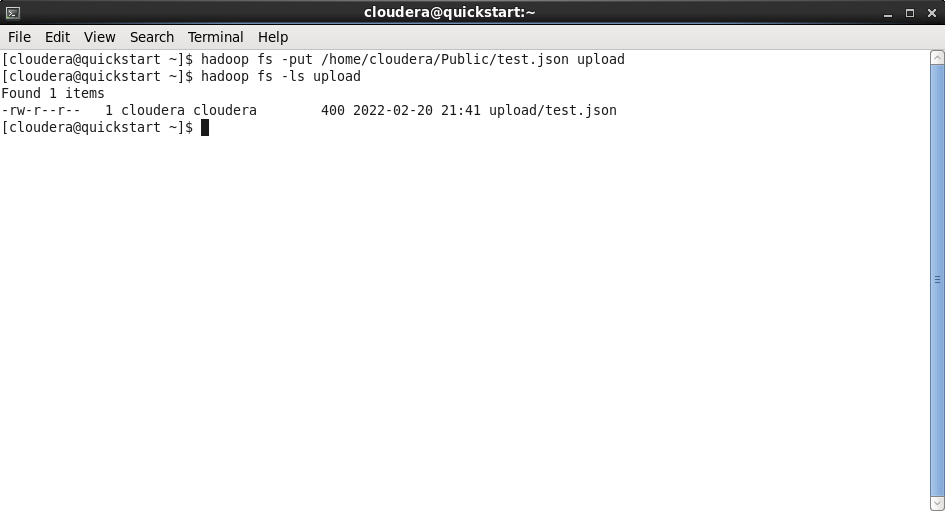

3. put 명령어를 통해서 파일을 upload 하면 된다.

(반대로 get을 하면 파일을 local로 가져올 수도 있다.)

$ hadoop fs -put [upload할 파일 (경로포함)] [어디에 넣을 것인지 Target 위치]

upload 폴더에 test.json 파일이 잘 전송된 것을 볼 수있다.

참고로 이 작업은 LOCAL에서 HDFS로 파일을 전송한 것이 아니다.

Cloudera 가 설치되어 있는 환경에 test.json 파일이 존재하고, Cloudera 환경에서 HDFS로 파일을 전송했다.

LOCAL에서 Cloudera환경으로 전송하는 방법은 SCP로 간단하게 할 수 있다.

728x90